📝 注:この記事は 2026 年 1 月 21 日に最終更新されました。最新の情報を提供するため、定期的に情報を更新しています!😊

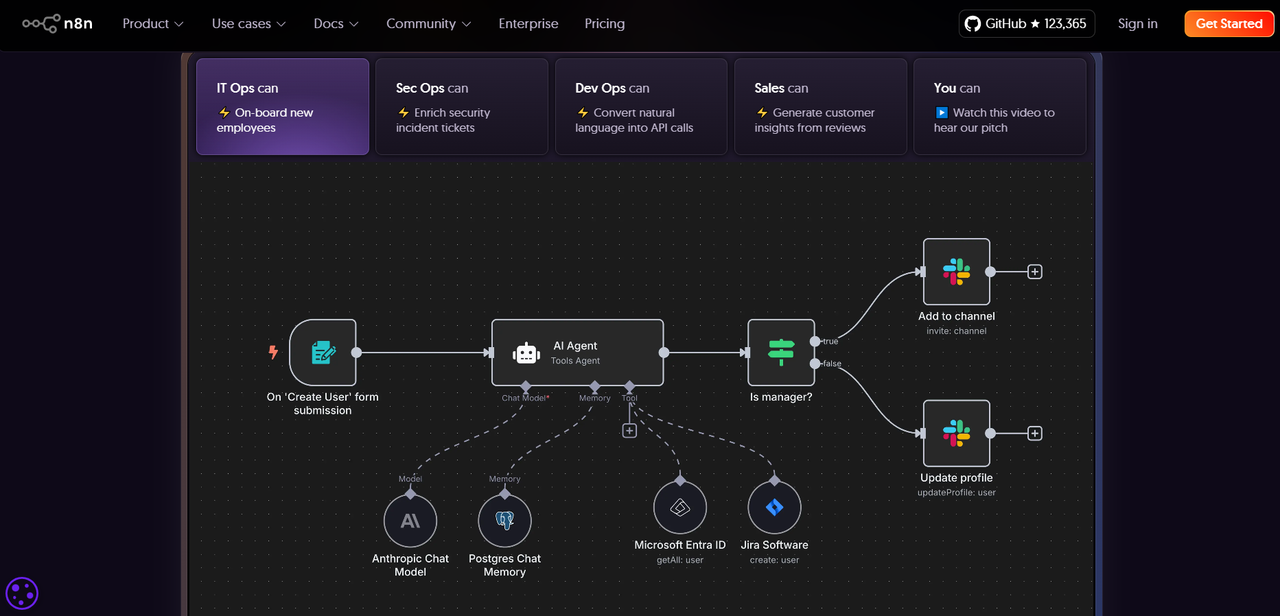

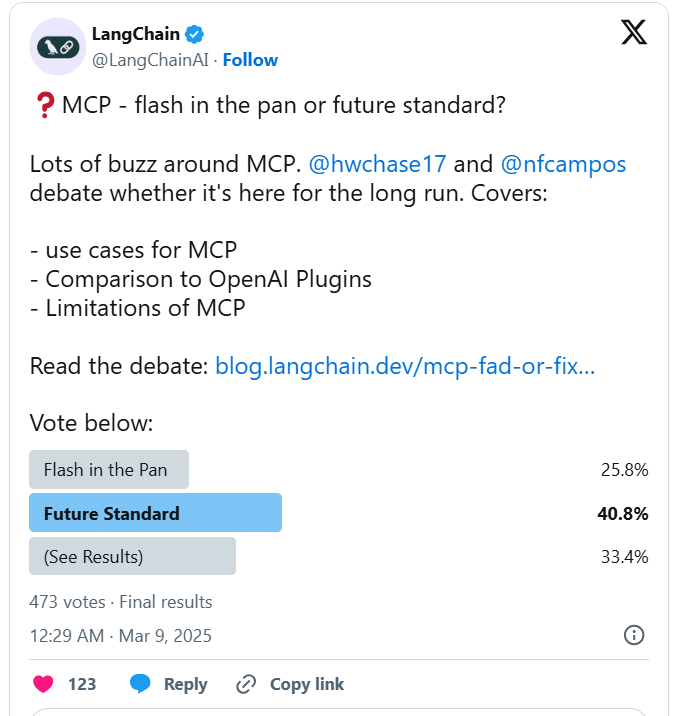

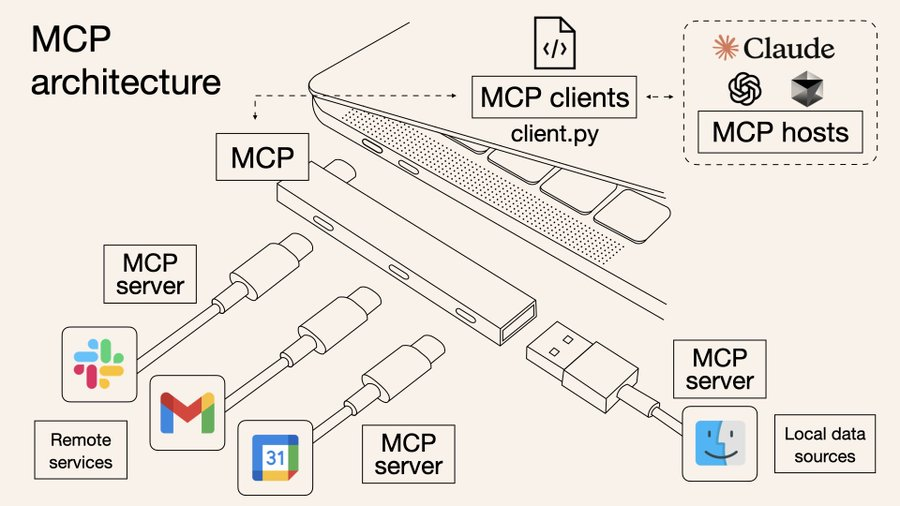

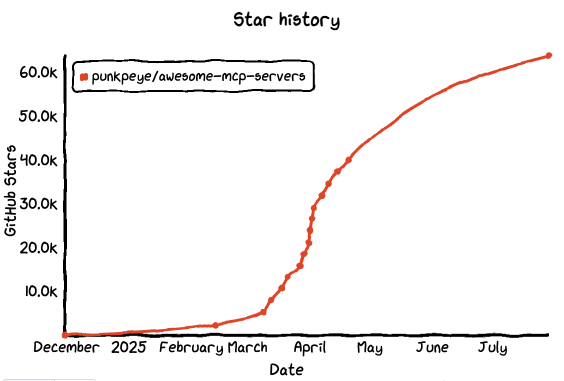

MCP(Model Context Protocol)という言葉が本格的に広く語られるようになったのは、2025 年初頭、特に AI ツール開発の界隈でした。3月には「 MCP は未来の標準プロトコルになり得るか?」という議論が盛り上がり、LangChain や LangGraph の主要メンバーが X 上で激しく討論。GitHub 上でも関連プロジェクトが次々と注目を集めました。

Image source: https://blog.langchain.com/mcp-fad-or-fixture/

なぜMCPが注目されたのか?

根本的な理由は、多くの開発者がようやく気づいたからです。ChatGPT はコンテンツを生成できても、Web ページを自動でクロールできない。Claude は PDF を理解できても、API を呼び出すことはできない。モデル自体は高性能ですが、「実行の完結性」に欠けており、ツール統合が依然としてボトルネックになっています。

MCP が解決しようとしているのは、まさにこの「最後の 1 マイル」の課題です。MCP は、AI がブラウザ、データベース、プラグインなどに統一的にアクセスできるようにする、いわば「 USB-C ポート」のようなもの。AI が“話す”だけでなく“動ける”ようにする仕組みです。

Image source: https://norahsakal.com/blog/mcp-vs-api-model-context-protocol-explained/

私たちは GitHub 上の優れたオープンソースプロジェクトを継続的にウォッチしていますが、MCP の理念に基づいたツールが次々と登場しており、自動化、プラグイン拡張、複数モデルの協調処理などに取り組んでいます。

この記事では、GitHub で話題の MCP 関連プロジェクトの中からスター数トップ 8 を厳選し、その概要、コア機能、導入方法、ユースケースを紹介します。実際のプロジェクト選定や構築の参考になれば幸いです。

💡 その他の人気シリーズもぜひご覧ください:

- GitHub のスター数上位 40 の開発者ツール

- 2025 年 GitHub 上で最も成長が速い上位 15 のオープンソース低コードプロジェクト

- GitHubスター数トップのオープンソースWebアプリ7選

💬 NocoBase ブログへようこそ。NocoBase は、あらゆる種類のシステム、業務アプリケーション、社内ツールを構築できる、拡張性に優れた AI 搭載のノーコード/ローコード開発プラットフォームです。完全なセルフホストに対応し、プラグインベースの設計で、開発者にもやさしい構成になっています。→ GitHub で NocoBase を見る

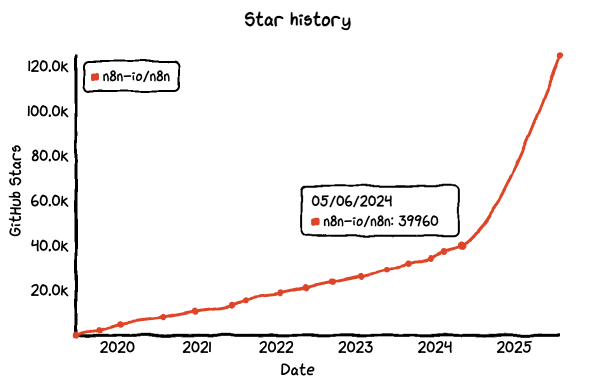

No.1: n8n

GitHub Star: 124k

GitHub: https://github.com/n8n-io/n8n

Website: https://n8n.io/

概要:

n8n は、過去 1 年間で急速に注目を集めたオープンソースの自動化ツールです。もともとは Zapier や Make のオープンソース代替として登場し、ビジュアルでさまざまな API やサービスを柔軟に接続できる点が特長です。

しかし、n8n の強みはそれだけにとどまりません。オープンソース、自律性、そして AI の活用ニーズが相まって爆発的な人気を得ました。OpenAI や Hugging Face などのモデルが企業利用に広がる中で、n8n は AI の呼び出しチェーン、スマートエージェント、業務アシスタントの構築に最適な選択肢として注目されています。外部のモデルサービスとの連携が容易で、カスタムロジックを通じて業務プロセスに AI を組み込み、実用的なインテリジェント自動化を実現できます。

主な機能:

- ビジュアルフロー構築: ノードをドラッグ&ドロップで接続し、サービスや操作を連携して自動実行フローを作成。

- Webhook および API 対応: Webhook ノードで AI Agent からの構造化リクエストを受信し、API ノードで外部システムにリクエストを送信可能。

- ロジックおよびデータ処理: 条件分岐、ループ、データ変換などを関数ノードで柔軟に実装し、タスク制御を実現。

デプロイと統合:

- 柔軟な導入方法: ローカル実行、Docker、ワンクリックインストール、クラウド展開に対応し、個人から企業まで幅広く対応可能。

- 強力なシステム統合: データベース、外部 API、GPT、ファイルサービスなど、500 以上の統合に対応。

n8n でできること:

- AI アシスタントによる外部サービス連携:「明日の午後に会議を設定して」とチャットに入力すると、n8n がリクエストを受信して対話コンテキストを抽出し、OpenAI に送信。意図を認識した後、n8n が Google Calendar に予定を自動登録し、確認メッセージを返信。

- 企業ナレッジベースの QA システム:「私たちの製品はどの支払い方法に対応していますか?」という質問に対し、n8n が社内ドキュメントのベクトル検索を行い、関連内容を抽出して文脈を構成。AI モデルに渡して正確な回答を生成し、Slack でユーザーに返信。

- モデル生成コンテンツの自動データベース登録: 毎日 GPT を定時実行して前日の営業チャットを要約し、n8n がキーワード、見込み客、次のアクションなどを抽出して CRM に保存。同時にチームチャットに日報要約を投稿。

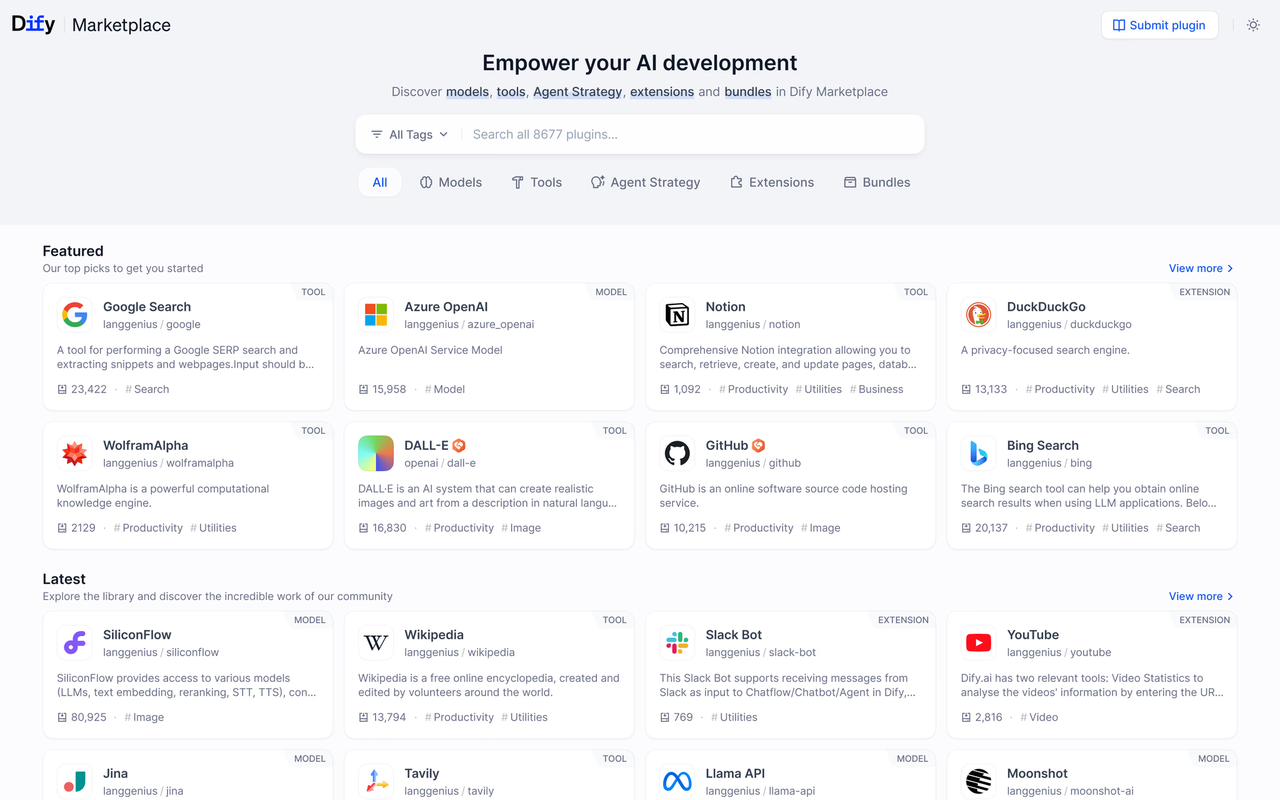

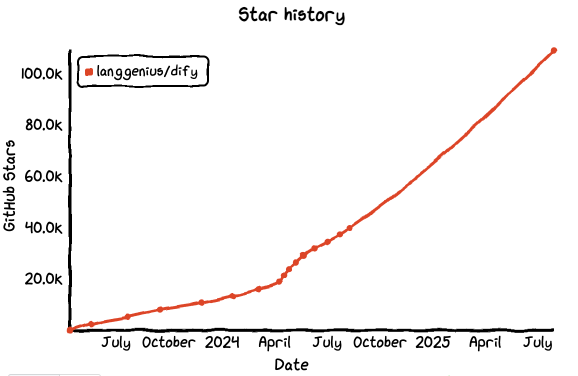

No.2: dify

GitHub Star: 109k

GitHub: https://github.com/langgenius/dify

Website: https://dify.ai/

概要:

Dify は、過去 1 年で急速に成長したオープンソースの AI アプリケーション開発プラットフォームです。最初は「すぐに使える LLM アプリ開発フレームワーク」として登場しましたが、現在ではチャットボット、Agent フロー、RAG システム、AI Copilot まで構築できるマルチモーダルな AI ワークベンチへと進化しています。

Dify は、OpenAI、Claude、Gemini などの主要モデルを呼び出せるだけでなく、複雑なコンテキスト設定や変数の受け渡しにも対応。さらに、データセット、ワークフロー、プラグインなどの機能が組み込まれており、ローコードで強力な LLM アプリを構築することができます。

主な機能:

- 双方向 MCP 対応: MCP サーバーとしてもクライアントとしても機能し、AI と外部システムとの指示・応答の連携をスムーズに実現。

- ビジュアルワークフロー構築: ドラッグ&ドロップで直感的に AI アプリや処理フローを作成可能。MCP 関連の処理設計を可視化し効率化。

- マルチモデルとツール統合: 世界中の大規模言語モデル(LLM)に対応し、プラグインや RAG パイプラインとの統合によって、柔軟な拡張が可能。

デプロイと統合: Docker や AWS AMI によるワンクリック導入に対応。SaaS 版も提供されており、API と Webhook インターフェースを通じて様々な環境で利用可能。

Dify でできること:

- 社内向けインテリジェントアシスタントの構築: 社内文書をアップロードし、OpenAI や Claude と連携させ、よくある質問や業務関連変数を設定することで、業務内容を理解したインテリジェントな社内用アシスタントを簡単に作成可能。Dify のフロントエンド SDK や API を使えば、自社サイトやシステムにも簡単に組み込み可能。

- 多ターン対応の RAG ベース QA アプリ構築: Dify に内蔵されたデータセット管理とコンテキスト制御を使えば、ベクトル検索を活用した多ターン対話型 QA システムを簡単に構築可能。ベクトル DB や Prompt 設計を自前で用意する必要がなく、資料のアップロードと設定だけで即稼働。カスタマーサポートや社内ナレッジベースに最適。

- ワークフローでモデルやツールを連携: Dify のワークフロー機能を使えば、複数モデルの呼び出し、プラグイン実行、API リクエストなどを連携し、複雑な Agent 処理が可能。たとえば、モデルがユーザーの意図を理解 → データベースを呼び出し → 結果を再加工 → 応答、という一連の流れをすべてビジュアルで設計できる。

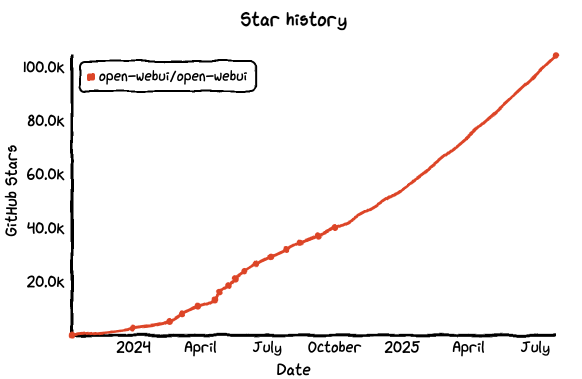

No.3: Open WebUI

GitHub Star: 104k

GitHub: https://github.com/open-webui/open-webui

Website: https://openwebui.com/

概要:

Open WebUI は、ローカル環境での利用に最適化された LLM チャットインターフェースです。OpenAI API、LM Studio、Ollama などのバックエンドモデルとシームレスに接続でき、軽量で高速、かつ複数モデルの切り替え、マルチユーザー対応、会話履歴の保存、プラグイン拡張などをサポートします。

「すぐに使える ChatGPT フロントエンド」として利用できるだけでなく、AI Copilot の UI 基盤として活用することもできます。導入が簡単で、UI も洗練されており、カスタマイズ性が高いため、社内ツールの構築にも広く使われています。

主な機能:

- マルチモデルと API 統合: OpenAI 互換 API や Ollama などの LLM ランタイムに対応し、共通のインターフェースで AI モデルの操作を一括管理。

- プラグインフレームワーク(Pipelines): カスタムの Python ロジックや機能プラグインを読み込み、前処理・後処理や外部ツール連携を実現。

- ローカル/リモートの RAG 対応: 内蔵の推論エンジンにより、ローカル文書の解析、外部ウェブ情報との連携、RAG パイプライン構築を通じてコンテキスト提供が可能。

デプロイと統合: Docker や Kubernetes による導入に対応。単体の開発環境から企業のクラスタ環境まで柔軟に対応でき、REST API 経由でモデルやプラグインと連携可能。

Open WebUI でできること:

- ChatGPT のプライベートコピーを構築: Open WebUI をローカルにデプロイされた LLM(たとえば Llama3、Mistral、Qwen など)と接続すれば、社内ネットワークで安全に ChatGPT のようなチャット体験が可能。マルチターン対応、モデル切り替え、会話履歴保存などにも対応し、業務アシスタントやナレッジ検索に最適。

- 開発チーム用の AI ツールボックスとして活用: プロンプト作成やモデル設定を個別に行う必要はありません。Open WebUI を使えば、共通のモデル設定やコンテキストテンプレートを一元管理でき、ユーザーごとの会話環境もロールベースで管理可能。チーム全体で統一された AI アシスタントを簡単に提供できます。

- LLM アプリの対話型フロントエンドとして利用: 務システムやデータベース、推論サービスと接続して、Open WebUI をアプリの UI レイヤーとして活用可能。プラグイン機構と API 統合を活かして、Q&A、検索、命令実行といった対話的処理を受け持つ軽量な Copilot フロントエンドを構築できます。

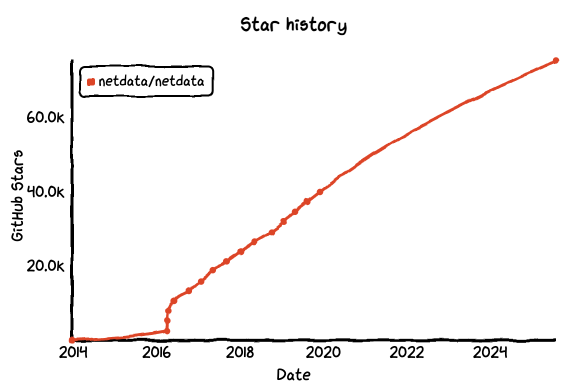

No.4: Netdata

GitHub Star: 75.2k

GitHub: https://github.com/netdata/netdata

Website: https://www.netdata.cloud/

概要:

Netdata は、リアルタイムで軽量なオープンソースのシステム監視プラットフォームです。サーバー、コンテナ、データベース、アプリケーションなどの稼働状況をほぼゼロ設定で即座に可視化できる点が特長です。従来の監視ツールに比べてレスポンスが非常に高速で、どんなシステムにも簡単に組み込めます。

大規模言語モデル(LLM)のデプロイや Agent のワークフローが複雑化する中、Netdata は多くの技術チームにとって MCP(Model Context Protocol)システムの「可観測性の中核」となっています。リソース使用状況だけでなく、推論レイテンシ、コンテキスト負荷、エラー情報なども可視化でき、AI 呼び出しチェーンの安定運用を支援します。

主な機能:

- MCP サーバー機能: Netdata Agent と Cloud モジュール自体が MCP サーバーとして動作し、AI から監視データへのアクセスを可能にします。

- リアルタイム監視と異常検出: 高頻度の性能メトリクス収集、ログ解析、アラート通知、異常検知機能を搭載。

- AI 支援の運用対話: 自然言語でインフラ状態を確認し、AI 駆動の DevOps アシスタントとして活用可能。

デプロイと統合: Docker、パッケージマネージャ、インストールスクリプトなどによって、サーバー、コンテナ、クラウド環境に柔軟に導入可能。800 以上の統合に対応し、標準化された MCP インターフェースを通じて AI Agent がリアルタイムに監視データを取得できます。

Netdata でできること:

- ローカル LLM のリソースをリアルタイムで監視: GPU、CPU、メモリ、ディスクなどの利用状況を秒単位で更新。ボトルネックやリソース過負荷をすぐに把握でき、ローカルモデルの運用に最適。

- AI ワークフロー用の監視ダッシュボードを構築: 推論 API の呼び出し回数、レスポンス時間、コンテキストキャッシュの使用状況などをリアルタイムで可視化。モデルの応答停止やエラー率の急上昇などを検知するアラートも設定可能。

- AI システムに可視化された「ブラックボックス」機能を追加: Netdata の詳細なトレースログや履歴グラフを使えば、障害発生時の状況を時系列で再現可能。RAG システムの故障、プラグインの接続失敗、GPU のクロック低下など、問題の特定と対処が容易になります。

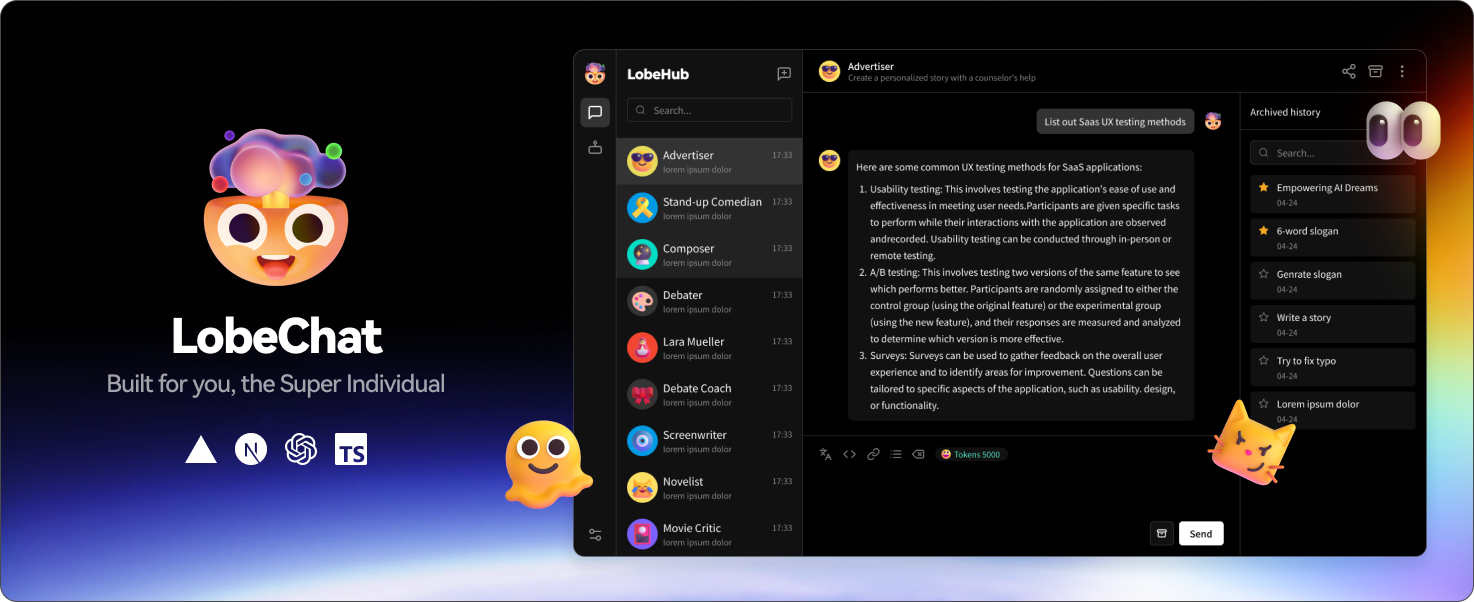

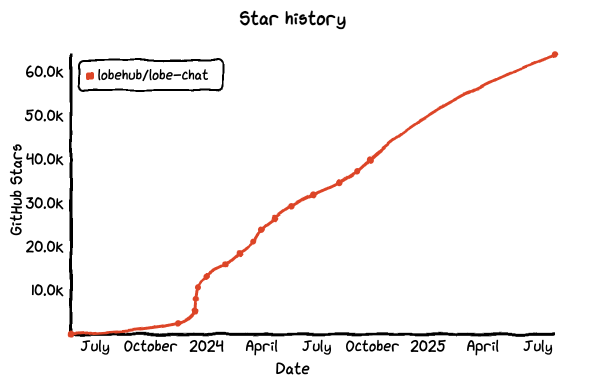

No.5: Lobe Chat

GitHub Star: 63.9k

GitHub: https://github.com/lobehub/lobe-chat

Website: https://lobechat.com/

概要:

Lobe Chat は、洗練された UI と強力な機能を備えたオープンソースの LLM チャットシステムです。複数モデル、マルチセッション、プラグインに対応しており、OpenAI、Claude、Gemini、Ollama など主要なモデルに完全対応しています。他のツールと比べ、Lobe Chat はユーザー体験と拡張性を重視しており、会話変数、プロンプトテンプレート、ロールプリセットなどの高度な機能を提供しています。個人使用だけでなく、チームが独自の Copilot を構築するのにも適しています。

MCP アーキテクチャがさまざまな AI アプリケーションで注目される中、Lobe Chat は文脈認識・マルチモデル呼び出し・プラグイン統合の能力を備えた「人間との対話層」の重要なフロントエンドとして台頭しています。

主な機能:

- 複数モデル & RAG 対応: OpenAI、Claude、Gemini、ローカルモデルを柔軟に統合し、ナレッジベース検索やコンテキスト参照を実現。

- MCP プラグインマーケット: MCP プラグインストアを内蔵し、エージェント機能やツール呼び出しを素早く導入可能。

- 機能呼び出しシステム: 関数呼び出し形式のプラグインプロトコルに対応しており、モデルをまたいだ外部処理が可能。

デプロイ & 統合: Docker や Vercel などでのセルフホスティングに対応し、プライベートなチャットアプリをワンクリックでデプロイ可能。外部システムとの統合用 API も提供。

Lobe Chat の活用シナリオ:

- 自分専用のマルチモデルアシスタントを構築: Llama3、Qwen、GPT-4、Claude などのローカル/クラウドモデルを簡単に統合し、統一されたチャット体験を実現。記憶、ロール設定、プラグイン呼び出しなど自由度が高く、ChatGPT よりも柔軟。

- プラグイン対応の AI Copilot を構築: データベース、検索エンジン、ツール API などに接続可能なプラグインを設定し、「この表を Notion に取り込み集計して」といった指示も自動実行可能。

- 共有可能な AI アプリ UI を構築: チャットだけでなく、カスタムエージェントやプロンプトツールの共有リンクや埋め込みを通じて、軽量な社内ツールや顧客向けサービスをすばやく構築可能。

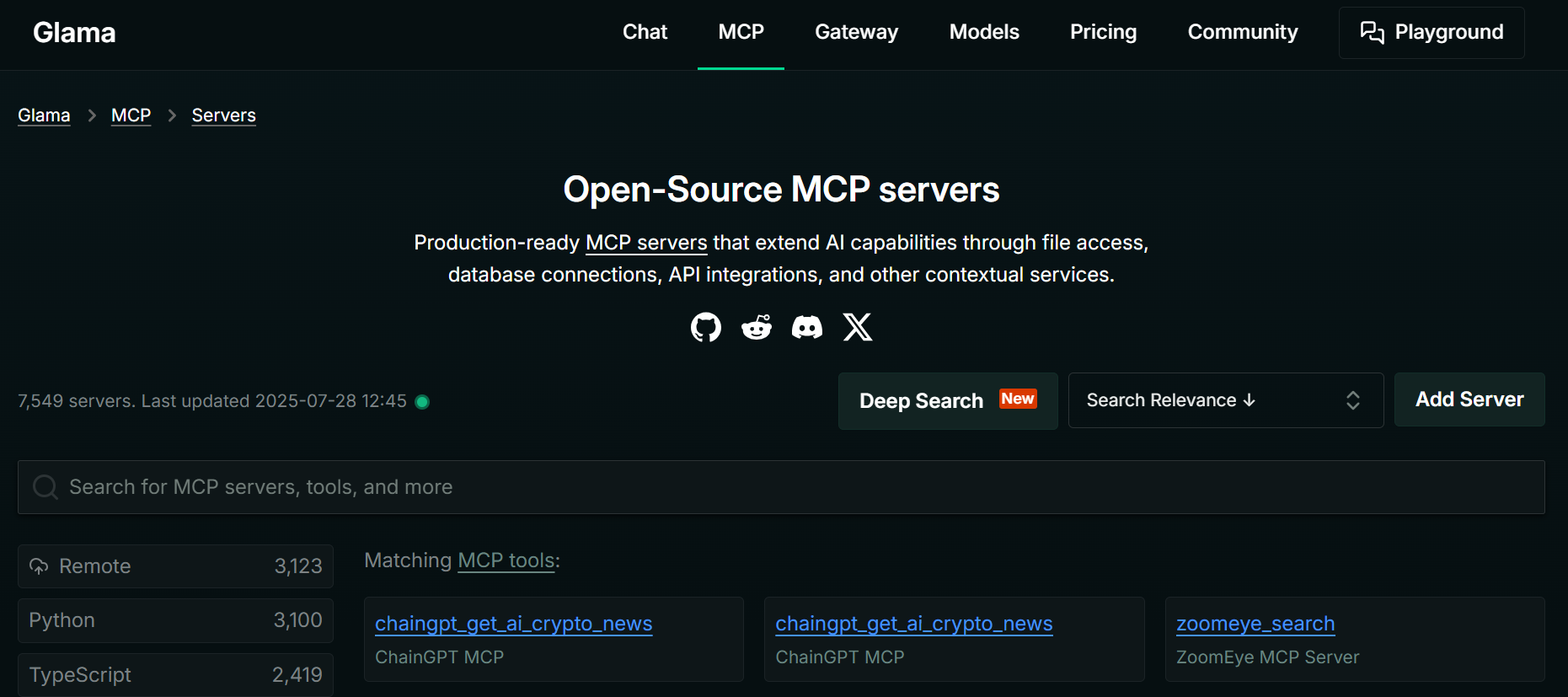

No.6: Glama

GitHub Star: 63.6k

GitHub: https://github.com/punkpeye/awesome-mcp-servers

Website: https://glama.ai/mcp/servers

概要:

Glama はこれまでのツールとは異なり、MCP プロトコル対応のオープンソースクライアントです。1 つの画面で複数の MCP 互換サービス(たとえば Lobe Chat や Open WebUI など)を接続・利用できます。モデル推論機能自体は持たず、「集約型インターフェース」として動作します。ChatGPT のように異なるモデルやプラグイン、コンテキストサービスを単一画面で切り替えながら使うことが可能です。

Glama は新しい「モジュール型体験」を提供し、任意の MCP 対応モデルバックエンド、複数のプラグインツールを自由に組み合わせて使えます。開発者や AI エンジニアにとっては、複数の AI サービスを観察・検証・協調する統合窓口となります。

主な機能:

- 多彩な MCP サーバー集約: Kong Konnect、Powerdrill、YingDao RPA、StarTree など多様な MCP サーバーを統合し、API ゲートウェイ、データ分析、RPA 自動化、DB 連携など多彩なシナリオをカバー。

- 標準化された相互運用性: 集約する MCP サーバーはすべて Model Context Protocol に準拠し、AI モデルが統一フォーマットで操作要求を送信可能。

- 効率的なリソース検索: MCP サーバーやツール名などキーワードで高速検索ができ、特定の業務要件に適合した MCP サービスを簡単に見つけられます。

デプロイ & 統合: ウェブ版サービスと API を提供し、法人ユーザーは自社システムや DB と直接連携可能。MCP プロトコルでタスク指示を受け取れます。

Glama の活用シナリオ:

- 複数 MCP サービスを一元管理するダッシュボード: Lobe Chat、Open WebUI など複数のチャットサービスや AI-Plugins Server など複数のプラグインサーバーを同時接続し、一つの画面で切り替えて使えます。統一された体験とコンテキスト管理が可能。

- エージェントとプラグインの協調動作を即テスト: Glama を使えば、異なる MCP バックエンドがプラグインをどう呼び出すか、ユーザー指示をどう解釈するかを直接検証可能。たとえばデータベースプラグインが全モデルで正常動作するか比較検証でき、システムチューニングに役立ちます。

- 「モデルクラスター+プラグイン」構成のプロトタイプ構築: AI Copilot 製品やプラットフォーム構築時の機能構造を Glama で試作可能。左画面にモデル、中央に対話画面、右にプラグインログ表示など MCP ベースの閉ループを可視化し、カスタム開発の基礎を固められます。

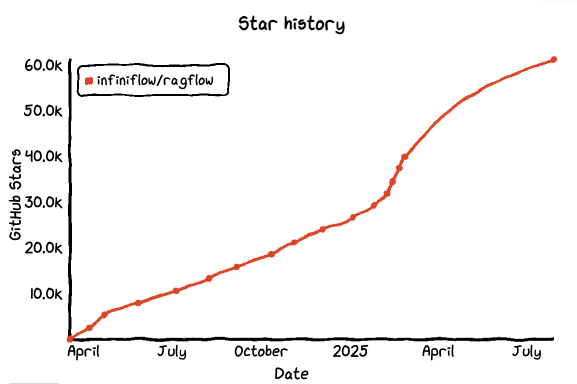

No.7: RAGFlow

GitHub Star: 61.1k

GitHub: https://github.com/infiniflow/ragflow

Website: https://ragflow.io/

概要:

RAGFlow は infiniflow チームが開発した、RAG(Retrieval-Augmented Generation)システム構築用のオープンソース開発フレームワークです。エンジニアリング重視で、モジュール化されたフロー設計、検索と生成の分離、コンテキストチェーンの可視化とデバッグ性を備えています。安定的かつ追跡可能な知識問答システム構築に最適なパイプラインツールといえます。

LangChain や LlamaIndex といった汎用フレームワークと比べ、RAGFlow は「バックエンド基盤」にフォーカスし、再現性・テスト性・可観測性を追求。複雑な QA システムや AI Copilot、企業知識検索などのチーム内利用に適しています。

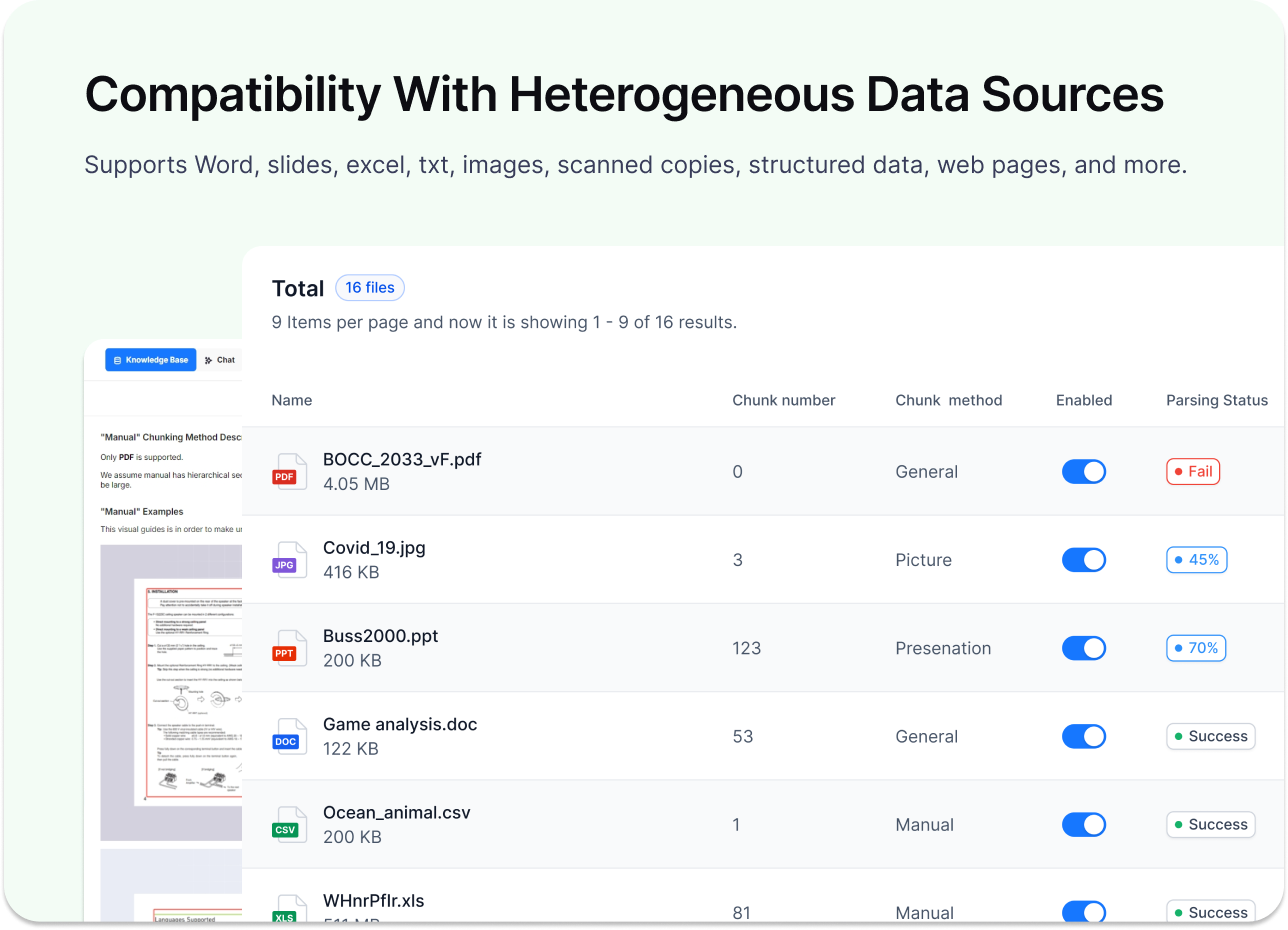

主な機能:

- 深層ドキュメント解析: 多形式ファイルや構造化データに対応し、重要情報を深く抽出して AI タスク向けに高品質コンテキストを提供。

- 知識ベース構築・管理: 専用の知識ベース作成をサポートし、アップロードファイルの解析、保存、保守が可能。

- 検索強化型生成連携: LLM 統合後、検索結果に基づいた正確な引用付き回答を生成。

デプロイ & 統合: Docker Compose によるデプロイを提供し、さまざまな LLM と統合可能。

RAGFlow の活用シナリオ:

- モジュール化された企業知識問答システム構築: 文書の前処理、チャンク分割、埋め込み生成、インデックス構造などを細かくモジュール設定でき、部品交換やカスタムノード追加も可能。業務に最適化した RAG システムを構築可能。

- デバッグ可能な RAG 呼び出しチェーン構築: どこで検索クエリが外れたか、どのコンテキストが長すぎてカットされたかを可視化。RAGFlow のチェーン可視化とデータトレーシングにより回答プロセスを効率的に改善。

- Agent と RAG 構成の統合: RAGFlow を Dify や Lobe Chat と連携し、プラグインや API 経由で複雑な意図認識 → 検索 → 回答の 3 段階処理を実装。財務アシスタントやカスタマーサポートなど高度な業務感知型エージェントに最適。

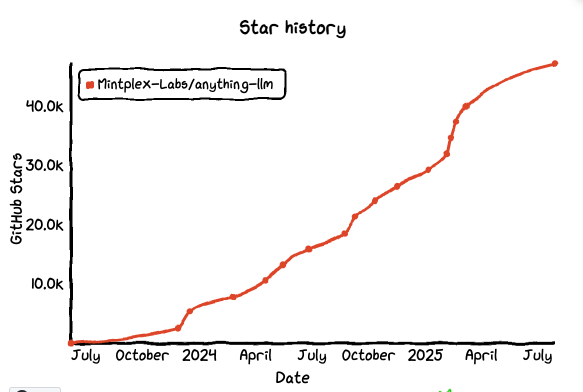

No.8: AnythingLLM

GitHub Star: 47.1k

GitHub: https://github.com/Mintplex-Labs/anything-llm

Website: https://anythingllm.com/

概要:

AnythingLLM は、RAG、AI エージェント、可視化/ノーコードのエージェントオーケストレーションを内蔵し、MCP にネイティブ対応したオープンソースのデスクトップ& Docker デプロイ対応フルスタックアプリです。複数モデルとローカル・クラウド向けベクトルDB に対応し、多人数利用や埋め込みチャットコンポーネントも提供。知識、モデル、ツールを迅速に組み合わせて利用可能で、プライベート運用やチーム協業に非常に適しています。

主な機能:

- マルチモデルとドキュメントインタラクション: ローカルカスタムモデルやクラウドモデル(OpenAI、Azure など)に対応し、PDF、Word、CSV 等多形式文書の処理が可能。

- カスタムエージェントとスキル拡張: Agent Skills による AI アシスタントのカスタム能力追加に対応し、MCP プロトコルと組み合わせて自動化タスク実行も可能。

- ローカル実行とプライバシー保護: LLM、ベクトルDB、ストレージコンポーネントをローカルで稼働し、AI コマンドやデータ処理はすべてローカルで完結。

デプロイ & 統合: デスクトップ向けワンクリックインストール対応。Docker によるセルフホスティングも可能。開発者向け API も提供し既存製品への組み込みに対応。

AnythingLLM の活用シナリオ:

- プライベート ChatGPT+知識ベース構築: PDF やウェブ資料を「Workspace」へドラッグし、自動チャンク化、埋め込み、引用付き回答生成。ローカル・クラウド運用問わず、チーム内の管理された問答入口を提供。

- Agent + MCP ツールチェーン実装: UI 上で MCP サーバーを設定し、対話中のエージェントが外部ツール(検索、クロール、DB 読み書き)を呼び出すことで「理解 → データ取得 → 処理 → 回答」の閉ループをノーコードで実現。

- マルチモデル&多ベクトルDB の柔軟組み合わせ: OpenAI、Claude、Gemini、ローカル Ollama など複数モデルを同時利用可能。LanceDB、PGVector、Pinecone、Milvus、Qdrant など多様なベクトルDB に対応。チャットコンポーネントはウェブやシステムへ埋め込み可能で、エンドツーエンドの完全な納品を実現。

総括

ここ数ヶ月で MCP はマニアックな概念から、開発者たちの間で熱く議論される話題に変わりました。標準はまだ完全に確定しておらず、ツールも日々進化していますが、多くのプロジェクトが MCP を用いて AI を単なる会話エンジンから、実際に「動かせる」システムへと進化させています。

AI 統合や自動化に取り組む開発者にとって、MCP は「モデルの知能だけでなく外部システムとの接続を重視し、現実の業務で AI が真価を発揮するための考え方」を示しています。

本稿が AI プロジェクトの統合や開発にあたって、何らかの参考やヒントになれば幸いです。

関連読み物: